2.2 Linha do tempo

Nesta seção acompanharemos um resumo da evolução histórica do Processamento digital de imagens. Iniciaremos na década de 1950, com os primeiros computadores eletrônicos de uso geral e o surgimento das primeiras aplicações de processamento de imagens, e seguiremos até a década atual com os desenvolvimentos das técnicas mais recentes de Inteligência Artificial e Aprendizado de Máquina. O uso de gráficos no computador não teria sido possível sem os esforços que contribuíram para o surgimento dos primeiros dispositivos de exibição, como o tubo de raios catódicos no final do século XIX.

1950 - 1960

Os primeiros computadores eletrônicos com dispositivos de exibição surgem neste período. O computador Whirlwind I, do MIT, originalmente projetado para ser parte de um simulador de vôo, foi um dos primeiros computadores digitais de uso geral com processamento em tempo real. O Whirlwind I era equipado com um CRT vetorial capaz de desenhar linhas e pontos.

Charles W. Adams e John T. Gilmore, programadores da equipe de desenvolvimento do Whirlwind, implementaram um programa de avaliação de equações diferenciais para produzir a animação da trajetória de uma bola quicando. Essa simulação pode ser considerada a primeira aplicação de computação gráfica interativa e o primeiro jogo de computador, pois o operador podia controlar, através de um botão, a frequência do quicar na tentativa de fazer a bola acertar uma lacuna na tela que simulava um buraco no chão.

O sistema de defesa aérea SAGE evoluiu a partir do Whirlwind ao longo da década de 1950. As estações do SAGE contavam com telas CRT que exibiam dados de diferentes radares combinados com informações de referência geográfica. Cada estação era também equipada com uma caneta óptica. Através da caneta óptica, o operador podia apontar e selecionar elementos gráficos diretamente na tela (figura 2.7).

em um CRT vetorial ([fonte](https://history-computer.com/sage-complete-history-of-the-sage-computer-system/)).](https://history-computer.com/ModernComputer/Electronic/Images/Sage_terminal.jpg)

Figura 2.7: Operador do SAGE usando uma caneta óptica em um CRT vetorial (fonte).

1960 - 1970

Foi nesse período que surgiram as primeiras aplicações de processamento de imagens digitais. Impulsionados principalmente pelos programas de exploração espaciais dessa época e pela de diagnósticos e aplicações médicas.

Em 1964, O laboratório de propulsão a jato da NASA fez uso de técnicas primitivas de computação para corrigir distorções de imagens da lua, essas imagens foram transmitidas pela sonda americana Ranger 7 para as câmeras televisivas da época.

![Imagem da lua capturada sonda espacial americana Ranger 7, capturada em 3 de julho de 1964 ([NASA]()).](images/01_nasa.jpg)

Figura 2.8: Imagem da lua capturada sonda espacial americana Ranger 7, capturada em 3 de julho de 1964 (NASA).

Em 1969, foi inventado o dispositivo de carga acoplada (em inglês charged-coupled device – CCD) nos laboratórios da Bell Labs. Esse dispositivo que foi inventado por Williard S. Boyle e George E. Smith serviu como base tecnológica para a criação dos sensores semicondutores que foram muito utilizado nas primeiras câmeras de vídeo digital (Boyle and Smith 1970).

1970 - 1980

Durante a década de 1970 as técnicas de processamento digital de imagens começaram a ser utilizadas nas áreas de medicina, observações remotas de recursos do planeta Terra, e nas áreas de Astronomia.

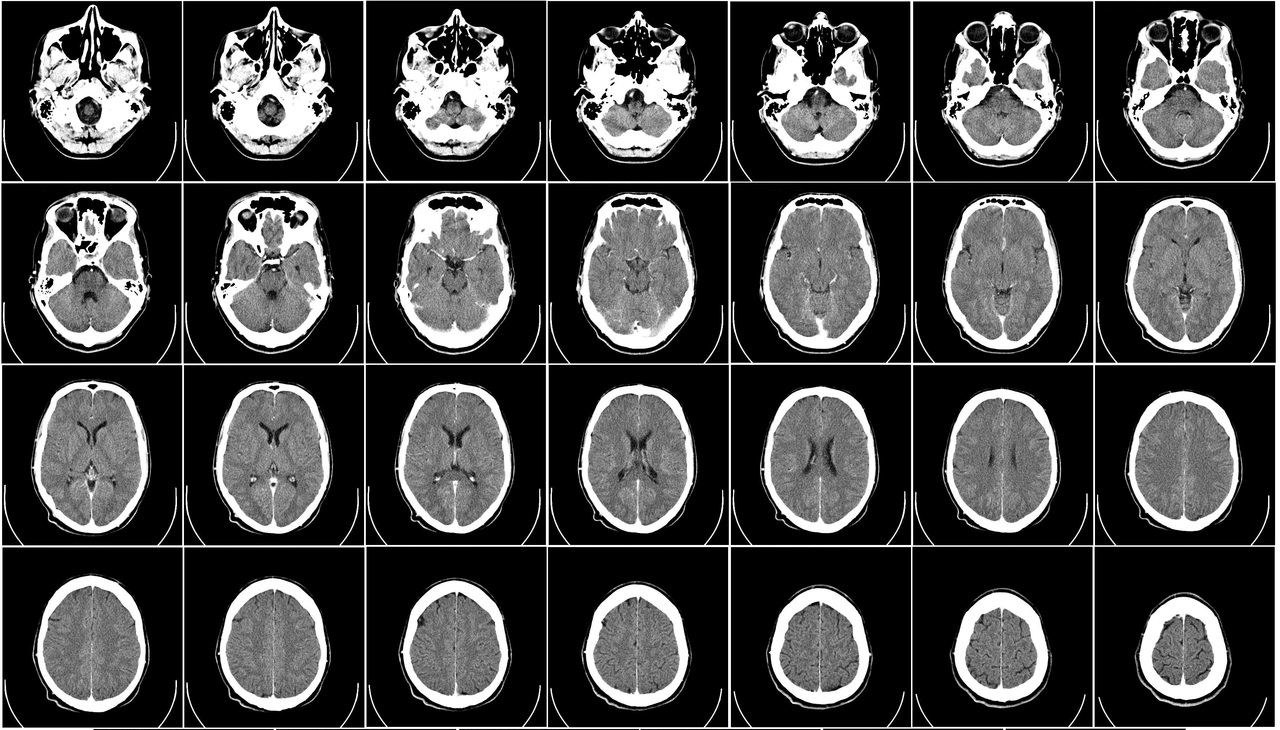

Um dos acontecimentos mais importantes dessa década foi a invenção da tomografia axial computadorizada, mais comumente chamada apenas de tomografia computadorizada.

Uma fonte de Raios-X é utilizada para coletar dados ao redor da circunferência de um anel, que percorre um objeto, ou um paciente, e assim gera imagens que representam uma fatia do objeto a ser observado.

Essa fatia contém informações do interior do objeto, e o conjunto de todas as fatias constituem a tomografia do objeto em questão. A tomografia gera um grande conjunto de imagens, onde cada fatia passa por um processamento de imagens para gerar informações uteis de diagnósticos. A tomografia foi inventada independentemente pelo professor Allam M Cormack e por Sir Godfrey B Hounsfield, que receberam o Prêmio Nobel de 1979 na área de medicina por essa invenção.

Figura 2.9: Visualização de uma tomografia computadorizada da cabeça, exibindo imagens das fatias de um crânio humano. É possível identificar com bastante detalhes as estruturas internas da cabeça tal como o cérebro, olhos e a boca.

Em 1972, foi desenvolvido uma importante tecnologia de compressão de imagens chamada de transformada discreta de cosseno. Essa técnica de compressão com perdas foi proposta por Nasir Ahmed e serviu como base para o padrão JPEG de compressão de imagens. Esse padrão comprime imagens para tamanhos muito pequenos sem muitas perdas visuais, sendo muito utilizado para imagens naturais, como fotografias. O Padrão JPEG foi apresentado pelo Joint Photographic Expert Group em 1992 e é um dos formatos de imagens mais utilizados até hoje.

1980 - 2000

Nesse período houve um grande desenvolvimento das tecnologias de captura de imagens e vídeos. Em 1985, a Olympus inventou o sensor de pixel ativos NMOS, que foi a tecnologia de referência para o desenvolvimento dos sensores do tipo CMOS, inventado em 1993 pelo laboratório de propulsão a jato da NASA. Essas tecnologias são utilizadas atualmente para a captura de imagens e são utilizadas em praticamente todos os dispositivos de imagem e vídeo, desde câmeras de celulares, passando a câmeras profissionais utilizadas no cinema, a até dispositivos laboratoriais de captura de luz.

](images/01_cmos.jpg)

Figura 2.10: Sensor CMOS utilizado em câmeras digitais. fonte

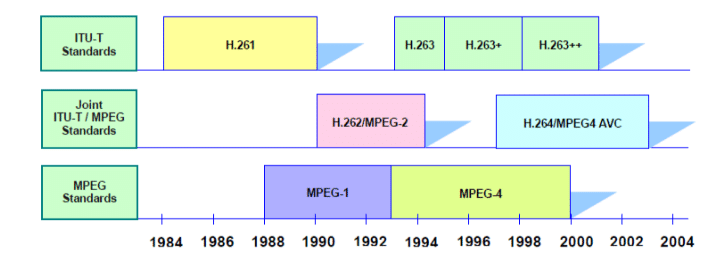

Foi nesse período que foram desenvolvidos os principais padrões de codificação, compressão e armazenamento de imagens e vídeos, entre eles estão os famosos GIF (1987), JPEG (1992) e PNG(1995). Em 1988 foi criado a aliança Moving Picture Experts Group (MPEG), que estabeleceu diversos padrões de codificação, compressão, transmissão e armazenamento de áudio, vídeo e gráficos. Junto a aliança JPEG, foi estabelecido diversos padrões que foram e ainda são utilizados.

Figura 2.11: Linha do tempo dos padrões MPEG e ITU.

Um dos primeiros padrões estabelecidos foi o MPEG-1 em 1993, que trazia informações de codificação de áudio e vídeo em mídias digitais a uma taxa de até 1.5 Mbits/s. Esse padrão foi utilizado principalmente em CDs (Compact Discs). O mais famoso dos formatos contidos nesse padrão é o MPEG-1 Audio Layer III, chamado popularmente de MP3, formato que ainda é muito utilizado atualmente para armazenamento de áudio e músicas utilizando uma compressão com perdas.

Em 1996 foi estabelecido o padrão MPEG-2, esse padrão determinava a codificação de vídeo e áudio e foi adotado para boa parte das transmissões de TV digital, esse também foi o formato adotado para os filmes em discos de DVD.

O padrão MPEG-4 foi criado em 1998 e suporta não somente áudio e vídeo, mas como também aplicações desenvolvidas em Java e soluções de gerenciamento de propriedade, que possibilita o controle de direitos evitando assim a pirataria e uso ilegal de conteúdo. Esse padrão utiliza técnicas avançadas de processamento de imagens e foi o padrão adotado pelo ISDB-TB, que é o padrão de televisão digital brasileiro. Esse também é o padrão utilizado na maioria dos discos de Blu-ray (BD) e contém padrões muito utilizados atualmente em streaming de conteúdos, em serviços como YouTube, Netflix, PrimeVideo, entre outros. O Video Coding Experts Group (VCEG) é outro grupo responsável pela criação de padrões de vídeo que faz parte do grupo Telecommunication Standardization Sector (ITU-T). Esse grupo se juntou ao MPEG para a criação do padrão MPEG-2 e do protocolo MPEG-4 AVC.

2000 - Atualmente

Atualmente, o grande desafio é o desenvolvimento de tecnologias com suporte a grandes resoluções e alta qualidade de imagem. Boa parte das televisões utilizam painéis com suporte a resolução de 4K (3840 x 2160 pixels) e já há modelos com resolução de 8k (7680 x 4320 pixels). Embora o hardware gráfico e o poder de processamento tenha evoluído, esse aumento drástico na quantidade de pixels e taxa de atualização dos dispositivos de exibição exige que novas soluções sejam desenvolvidas. Um exemplo prático do poder requirido: para uma TV 8K capaz de operar em uma frequência de 120 Hertz, exige o processamento de 4 bilhões de pixels por segundo (3.981.312.000). Supondo que um pixel esteja codificado em um padrão de 3 cores, isto significa aproximadamente 12 bilhões de operações por segundo.

Além da evolução na frequência e resolução, há ainda inovações no padrão de representação das cores, como o uso de padrões com suporte a High Dynamic Range (HDR), que utilizam uma quantidade maior de bits para representar as cores, exigindo um maior poder de processamento.

Com a prevalência dos serviços de streaming, outro desafio é fornecer conteúdo com grande qualidade visual utilizando uma taxa de transferência de bits baixa, isso só é possível com o desenvolvimento de técnicas de compressão e de transmissão de imagens e vídeos.

Além da qualidade de imagem, outro ponto que vem se tornando cada vez mais importante é a disponibilização de conteúdo com baixa latência. Esse ponto é particularmente importante para serviços executados em cloud e em tempo real, tal como conferências, vídeo chamadas, jogos interativos em nuvem, entre outros.

A área de processamento de imagens também é um grande aliado da inteligência artificial e dos algoritmos de aprendizado de máquina. Normalmente, métodos de processamento de imagens são utilizadas em conjunto com técnicas de visão computacional para identificar padrões, e processar informações em algoritmos de aprendizado de máquina a fim de gerar aplicações inteligentes. Técnicas de processamento de imagem, como a filtragem utilizando convolução são bases para redes neurais artificiais como a redes de convolução utilizadas atualmente. Há uma grande intersecção entre as áreas da computação visual que incluem o processamento de imagens, visão computacional e aprendizado de máquina aplicado a imagens e vídeos.